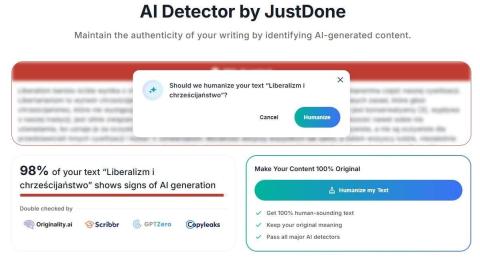

Tekst, który napisałem w 2014 roku, detektor sztucznej inteligencji uznał za napisany przez sztuczną inteligencję w 98%. I zaproponował, iż może mi go zhumanizować, a zatem przerobić na taki, iż on sam uzna, iż tego nie napisała sztuczna inteligencja. Detektory AI głównie po takich cechach rozpoznają teksty napisane przez AI:

- Styl i „gładkość” — długi, dobrze złożony, logiczny tekst o spójnym, równym rytmie może przypominać to, co generują modele (niskie „perplexity”).

- Powszechne zwroty i frazy — jeżeli używam sformułowań często pojawiających się w internecie, klasyfikator je rozpoznaje jako typowe dla tekstów treningowych.

- Brak osobistych, unikalnych szczegółów — tekst, który nie zawiera lokalnych detali, anegdot, dat, imion, potocznych zwrotów — łatwiej sklasyfikować jako „ogólnie wygenerowany”.

- Format i długość — średnio-długie, sfokusowane eseje są trudniejsze do rozróżnienia; krótsze lub bardziej chaotyczne teksty bywają „bardziej ludzkie” w oczach detektorów.

Ja jestem blogerem i od ponad 30 lat piszę notki blogowe. Te wymienione cechy, to cechy mojego stylu, ja się celowo od lat ćwiczę w tym, by właśnie tak pisać, by pisać klarownie, sensownie, by unikać anegdot i wtrętów osobistych, by nie operować emocjami, staram się używać sprawnych logicznie argumentów.

Dodatkowo czasem biorę stare moje notki i rozmawiam o nich z AI, prosząc o wygładzenie stylu, ominięcie powtórzeń i doprowadzenie tekstu do perfekcji, tak by idealnie oddawał to, o co mi chodziło. A potem detektor uznaje, iż to 100% "AI generated".

Jeśli ludzie taką ocenę uznają za deprecjonującą, to znaczy, iż blogerzy korzystający z AI będą jej kazać psuć i brudzić teksty, wkładać bzdurne anegdotki i osobiste, emocjonalne uwagi. To bez sensu!

Jeśli jakaś AI umie ocenić, iż dany tekst jest generowany przez AI, to znaczy, iż ona sama potrafi go tak przerobić, by nie oceniała go na wygenerowanego przez AI. To będzie niekończąca się zabawa w kotka i myszkę. A przecież chodzi o to, by pisać teksty klarowne, logiczne, sensowne, mądre — jeśli AI w tym pomaga, to dobrze, to lepiej, jakość tego, co piszemy i czytamy, się podnosi. Więc detektory AI są bez sensu i służą temu, byśmy w istocie pisali coraz gorzej, a nie coraz lepiej.

A tu ten sam tekst wygładzony przez AI:

Detektory AI rozpoznają teksty po cechach statystycznych — stylu, spójności, powtarzalnych fraz, braku „brudu” osobistego i przewidywalnej długości.

To są cechy mojego stylu. Piszę notki od 30 lat. Celowo: czysto, logicznie, bez anegdot, bez emocjonalnych wtrętów. Moim celem jest argument, nie show.

Czasem biorę swoje stare szkice i proszę LLM o wygładzenie — o usunięcie powtórzeń, ostrzejsze zdanie, poprawę logiki. To narzędzie redakcyjne. A potem automat mówi: „100% AI generated”. Kto tu oszukuje?

Jeśli detektory mają być używane jako autorytet, to w praktyce będą wymuszać regres stylu — blogerzy będą musieli „brudzić” teksty anegdotami i osobistymi wtrętami, żeby nie wyglądały „jak z AI”. To absurd.

Jeżeli AI może wykryć cechy, to technicznie może też wygenerować wersję, która te cechy ukryje. To kotek-i-myszka bez końca. Problem nie techniczny — problem instytucjonalny: detektory bez kontekstu niszczą reputację autorów i degradują jakość pisania.

Grzegorz GPS Świderski

]]>https://t.me/KanalBlogeraGPS]]>

]]>https://Twitter.com/gps65]]>

PS. Tu tekst, który wymyślona przeze mnie AI napisała w 2014 roku: ]]>https://www.salon24.pl/u/gps65/490816,libertarianizm-a-chrzescijanstwo]]>