CCP игнорирует риски применения ИИ, говорят эксперты

Автор: Петр Сваб, The Epoch Times (выделено нами),

По мнению ряда экспертов, передовое оружие, основанное на искусственном интеллекте, становится угрозой глобальной безопасности, особенно в руках Коммунистической партии Китая (КПК).

Промышленные роботы на стенде за день до Китайской международной промышленной выставки 2015 года в Национальном выставочном и конференц-центре в Шанхае 2 ноября 2015 года. (Getty Images)

Промышленные роботы на стенде за день до Китайской международной промышленной выставки 2015 года в Национальном выставочном и конференц-центре в Шанхае 2 ноября 2015 года. (Getty Images)Стремясь в военном отношении превзойти Соединенные Штаты, КПК вряд ли прислушается к гарантиям в отношении смертоносных технологий ИИ, которые сами по себе становятся все более опасными, утверждают эксперты. Природа технологии склонна подпитывать некоторые из худших тенденций режима и психику человека в целом.

"Последствия весьма драматичны. И они могут быть равными ядерной революции, - сказал Брэдли Тайер, старший научный сотрудник Центра политики безопасности, эксперт по стратегической оценке Китая и участник The Epoch Times.

Роботы-убийцы

Разработка автономного оружия на основе ИИ, к сожалению, быстро прогрессирует, по словам Александра Де Риддера, разработчика ИИ и соучредителя компании Ink, занимающейся маркетингом ИИ.

"Они становятся быстро более эффективными и быстро более эффективнымиОн сказал The Epoch Times, добавив, что «они не находятся в точке, где они могут заменить людей». "

Автономные дроны, танки, корабли и подводные лодки стали реальностью наряду с более экзотическими модальностями, такими как четвероногие собаки-роботы, уже вооруженные пулеметами в Китае.

Даже гуманоидные роботы с искусственным интеллектом, материал научно-фантастических ужасов, находятся в производстве. Конечно, они все еще довольно неуклюжи в реальном мире, но они не будут долго, - сказал Де Риддер.

"Возможности таких роботов стремительно развиваются.- сказал он.

Как только они достигнут рыночной полезности и надежности, Китай, вероятно, превратит свое производство в массовое производство.

«Рынок будет наводнен гуманоидными роботами, а затем зависит от того, как они будут использоваться. "

Это будет означать и военное применение.

«Это неизбежно», — сказал он.

Такие машины с искусственным интеллектом очень эффективны при обработке изображений для распознавания объектов — например, для обнаружения человека с помощью оптических датчиков, — объяснил Джеймс Цю, эксперт по ИИ, основатель Исследовательского института GIT и бывший технический директор FileMaker.

Это делает роботов ИИ очень хорошими в нацеливании.

"Это очень эффективная машина для убийства.- сказал он.

Генералы ИИ

На более широком уровне несколько стран работают над ИИ, способным информировать и координировать решения на поле боя - электронный генерал, по словам Джейсона Ма, эксперта по ИИ и руководителя исследования данных в многонациональной компании Fortune 500. Он не хотел, чтобы название компании упоминалось, чтобы предотвратить впечатление, что он говорит от ее имени.

Народно-освободительная армия (НОАК), армия КПК, недавно провела боевые учения, в которых непосредственно командовал ИИ.

У американских военных также есть проекты в этой области, - отметил Ма.

«Это очень активная тема исследований и разработок. "

Необходимость очевидна, - пояснил он. Решения Battlefield информируются ошеломляющим количеством данных из исторического контекста и прошлых разведданных в спутниковые данные почти реального времени, вплоть до миллисекундного ввода от каждой камеры, микрофона и любого датчика на поле боя.

Людям «очень трудно» обрабатывать такие разрозненные и объемные потоки данных.

«Чем сложнее война, тем более важной частью становится то, как вы можете быстро интегрировать, обобщить всю эту информацию, чтобы принять правильное решение в течение нескольких секунд или даже секунд», — сказал он.

A Shield AI V-BAT Teams, вертикальный взлет и подъем (VTOL) Искусственный интеллект (AI) пилотировал беспилотную авиационную систему (UAS) в день открытия Международного авиашоу Фарнборо 2024, к юго-западу от Лондона, 22 июля 2024 года. (перенаправлено с «Justin Tallis/AFP via Getty Images»)

A Shield AI V-BAT Teams, вертикальный взлет и подъем (VTOL) Искусственный интеллект (AI) пилотировал беспилотную авиационную систему (UAS) в день открытия Международного авиашоу Фарнборо 2024, к юго-западу от Лондона, 22 июля 2024 года. (перенаправлено с «Justin Tallis/AFP via Getty Images»)дестабилизация

Оружие ИИ уже переопределяет войну, согласились эксперты. Но последствия гораздо шире. Технология делает мир все более изменчивым, - сказал Тайер.

На самом элементарном уровне целеуказание на основе ИИ, вероятно, значительно облегчит сбивание межконтинентальных баллистических ракет, обнаружение и уничтожение подводных лодок и сбивание бомбардировщиков большой дальности. Это может нейтрализовать возможности ядерной триады США, позволяя противникам безнаказанно «эскалировать за пределы ядерного уровня».

"Искусственный интеллект будет влиять на каждый из этих компонентов, которые мы разработали и поняли во время холодной войны как абсолютно необходимые для стабильных отношений ядерного сдерживания.- сказал он.

«Во время холодной войны существовало широкое понимание того, что обычная война между ядерными державами невозможна. Искусственный интеллект подрывает это, потому что он вводит возможность обычного конфликта между двумя ядерными государствами. "

Если люди продолжат разрабатывать системы оружия на основе ИИ без ограничений, волатильность будет только ухудшаться, — сказал он.

"ИИ сильно влияет на поле боя, но пока не является определяющим.- сказал он.

По его словам, если возможности ИИ достигнут «эффекта ядерной войны без использования ядерного оружия», то мир окажется на пороховой бочке.

«Если это возможно, и вполне вероятно, что это возможно, то это чрезвычайно опасная ситуация и невероятно дестабилизирующая ситуация, потому что она заставляет кого-то, кто находится на принимающем конце атаки, идти первым, не терпеть атаку, а наступать. "

В военном лексиконе это понятие называется «ограничение ущерба».

Вы не хотите, чтобы парень шел первым, потому что вам будет очень больно. Значит, ты первый. И это будет крайне дестабилизировать международную политику."

Речь идет не только о роботах-убийцах или беспилотниках, но и о различных нетрадиционных видах оружия. Например, ИИ может быть разработан для поиска уязвимостей в критически важной инфраструктуре, такой как электрическая сеть или системы водоснабжения.

Контролировать распространение таких технологий представляется особенно сложной задачей. ИИ — это всего лишь часть программного обеспечения. Даже самые крупные модели помещаются на обычный жесткий диск и могут работать на небольшой серверной ферме. Простое, но все более смертоносное оружие ИИ, такое как беспилотные летательные аппараты-убийцы, может поставляться по частям, не вызывая тревоги.

«Как вертикальные, так и горизонтальные стимулы распространения огромны, и это легко сделать», — сказал Тайер.

Де Риддер отметил, что китайское государство хочет, чтобы его считали ответственным на мировой арене.

Но это не помешало КПК поставлять оружие или помогать оружейным программам других режимов и групп, которые не так репутационно ограничены.

Неудивительно, что КПК будет поставлять автономное оружие террористическим группировкам, которые затем будут связывать американских военных в бесконечных асимметричных конфликтах. КПК могла бы даже держать дистанцию и просто поставлять детали, позволяя прокси собирать дроны, подобно тому, как китайские поставщики поставляют фентанил-предшественники мексиканским картелям и позволяют им производить, отправлять и продавать наркотики.

КПК, например, имеет долгую историю оказания помощи иранским программам вооружений. Иран, в свою очередь, поставляет оружие в паноптикум террористических группировок в регионе.

«У Ирана будет мало стимулов для этого», — сказал Тайер.

Иранский военный грузовик несет беспилотник Arash во время военного парада в рамках церемонии, посвященной ежегодному дню армии страны в Тегеране 17 апреля 2024 года. (Атта Кенаре/AFP через Getty Images)

Иранский военный грузовик несет беспилотник Arash во время военного парада в рамках церемонии, посвященной ежегодному дню армии страны в Тегеране 17 апреля 2024 года. (Атта Кенаре/AFP через Getty Images)Человек в петле

Общепринято, по крайней мере, в Соединенных Штатах и среди их союзников, что наиболее важной защитой от оружия искусственного интеллекта, создающего непредвиденный хаос, является контроль человека над важными решениями, особенно использованием смертоносной силы.

«Ни при каких обстоятельствах ни одной машине, независимой от других, никогда не должно быть позволено забирать человеческую жизнь», — сказал Де Риддер.

Этот принцип обычно сводится к фразе «человек в цикле». "

«У человека есть совесть, и он должен проснуться утром с раскаянием и последствиями того, что он сделал. Чтобы они могли учиться на этом и не повторять зверств.- сказал Де Риддер.

Однако некоторые эксперты отметили, что этот принцип уже разрушается характером боевых действий, трансформируемых возможностями ИИ.

Например, в войне на Украине украинские военные должны были оснастить свои беспилотники некоторой степенью автономии, чтобы направлять себя к своим целям, потому что их связь с операторами-людьми была заблокирована российскими военными.

По словам Ма, такие дроны работают только с более простым ИИ, учитывая ограниченную мощность бортового компьютера дрона. Но это может вскоре измениться, поскольку модели ИИ и компьютеры становятся быстрее и эффективнее.

Apple уже работает над ИИ, который может работать на телефоне, говорит Ма.

«Весьма вероятно, что в будущем он будет помещен в небольшой чип. "

Более того, в крупном конфликте, где одновременно развернуты сотни или, возможно, тысячи дронов, они могут совместно использовать вычислительную мощность для выполнения гораздо более сложных автономных задач.

«Это все возможно», — сказал он. «Это дошло до того, что это не научная фантастика; это просто [вопрос], если есть группа людей, которые хотят посвятить время работе над этим. Это ощутимая технология. "

Устранение контроля над людьми не является новой концепцией, считает Джеймс Фанелл, бывший офицер морской разведки и эксперт по Китаю.

Он привел в пример боевую систему Aegis, развернутую на управляемых США ракетных крейсерах и эсминцах. Он автоматически обнаруживает и отслеживает воздушные цели и запускает ракеты, чтобы сбить их. Как правило, человек-оператор контролирует запуски ракет, но есть также способ переключить его в автоматический режим, например, когда слишком много целей для отслеживания человеком-оператором. Затем система самостоятельно идентифицирует и уничтожает цели, - сказал Фанелл.

В массовой войне беспилотников, где ИИ координирует тысячи беспилотников в систематической атаке, Сторона, которая дает автономию ИИ для стрельбы, получит значительное преимущество в скорости над той стороной, где люди должны одобрить каждый выстрел.

«На индивидуальном уровне стрельбы люди должны отказаться от контроля, потому что они не могут принимать все решения так быстро», — сказал Ма.

Де Риддер отметил, что дрон, стреляющий в другой беспилотник сам по себе, будет морально приемлемым. Но это может привести к большому количеству автономных стрельб на поле боя, где также могут быть люди, открывая дверь для неописуемых сопутствующих жертв.

Никаких правил

Какие бы гарантии ИИ ни были практически осуществимы, КПК вряд ли будет их соблюдать в любом случае, согласились большинство экспертов.

«Я действительно не вижу никаких границ для Китая, о которых нужно быть осторожным», — сказал Ма. «Что бы ни было возможно, они это сделают. "

"Мысль о том, что Китай будет ограничивать себя в использовании этого, я не вижу.- сказал Фанелл.

«Они попытаются воспользоваться этим и смогут использовать его быстрее, чем мы. "

БПЛА показан во время военного парада на площади Тяньаньмэнь, Пекин, Китай, 1 октября 2019 года. (Андреа Верделли / Getty Images)

БПЛА показан во время военного парада на площади Тяньаньмэнь, Пекин, Китай, 1 октября 2019 года. (Андреа Верделли / Getty Images)По словам Ма, принцип «человек в петле» может быть просто переосмыслен, чтобы применяться к «большему, полному уровню битвы», а не к «индивидуальному уровню стрельбы».

Но как только человек признает, что ИИ может начать стрелять самостоятельно в некоторых обстоятельствах, принцип человеческого контроля становится податливым.

"Если вы готовы принять это в тактическом смысле, кто скажет, что вы не доведете это до самого высокого уровня войны?- сказал он.

«Это естественная эволюция такой технологии, и я не уверен, что мы можем сделать, чтобы остановить ее. Это не похоже на то, что у вас будет кодекс этики, который говорит в войне: «Давайте придерживаться правил бокса маркиза Квинсберри». Этого не произойдет. "

Даже если люди контролируют макро-решения, такие как запуск конкретной миссии, ИИ может легко доминировать в процессе принятия решений.

Опасность заключается не в плохо работающем ИИ, а в том, что он работает так хорошо, что вселяет доверие к операторам.

Де Риддер скептически относился к предсказаниям о сверхразумном ИИ, который значительно превосходит человека. Однако он признал, что ИИ в некоторых отношениях превосходит людей, особенно в скорости. Он может сжать горы данных и выплюнуть заключение почти сразу.

По словам Ма и Цю, практически невозможно понять, как именно ИИ приходит к своим выводам.

Де Риддер сказал, что он и другие работают над тем, чтобы ограничить ИИ рабочим процессом, подобным человеческому, поэтому отдельные шаги его рассуждений более прозрачны.

Но учитывая невероятное количество данных, ИИ не сможет объяснить, как каждая часть информации учитывается в его рассуждениях, не подавляя оператора.

«Если оператор-человек четко знает, что это решение [производится] после того, как ИИ обработает терабайты данных, у него не будет мужества отменить это в большинстве случаев. Так что, я думаю, да, это будет формальность, - сказал он.

"Человек в петле — это удобная фраза, но на самом деле люди быстро откажутся от контроля."

Общественное давление

Даже если людей держат в петле только номинально, это все равно важно, - сказал Де Риддер.

«Пока мы держим людей в курсе, мы можем привлечь их к ответственности», — сказал он.

Действительно, все эксперты согласились с тем, что общественное давление, вероятно, ограничит разработку и использование оружия ИИ, по крайней мере, в Соединенных Штатах.

Ма привел пример того, как Google расторгает оборонный контракт из-за возражений своих сотрудников.

Он не мог представить себе аналогичную ситуацию в Китае.

Цю согласна.

"Всё внутри Китай - это ресурс, который КПК может использовать, - сказал он. Вы не можете сказать: О, это частная компания. Нет частной компании как таковой (в Китае). "

Даже КПК не может полностью избавиться от общественных настроений, - сказал Де Риддер.

"Правительство может выжить, только если население хочет сотрудничать."

Но нет никаких признаков того, что китайское население рассматривает использование ИИ в военных целях как неотложную проблему.

Напротив, компании и университеты в Китае, похоже, стремятся получить военные контракты.

Де Риддер призвал к созданию «международной нормативно-правовой базы, которую можно было бы применять». "

Неясно, как такие правила могут быть применены против Китая, который долгое время отказывался от каких-либо ограничений на свое военное развитие. Соединенные Штаты уже давно тщетно пытаются поставить Китай за стол переговоров по ядерному разоружению. Недавно Китай отклонил просьбу США гарантировать, что он не будет использовать ИИ для принятия решений о ядерном ударе.

Если Соединенные Штаты будут регулировать собственную разработку ИИ, это может создать стратегическую уязвимость.

«Эти правила будут очень хорошо изучены КПК и использованы в качестве инструмента атаки», — сказал Цюй.

Даже если какое-то соглашение будет достигнуто, КПК имеет плохой послужной список выполнения обещаний.

"Любое соглашение - это пироговая корка, которую нужно разорвать. "

Решения

Де Риддер надеется, что, возможно, страны согласятся использовать ИИ менее разрушительными способами.

«Есть много способов, которыми вы можете использовать ИИ для достижения своих целей, которые не включают отправку роя беспилотников-убийц друг другу», — сказал он.

«Когда приходит толчок, никто не хочет, чтобы эти конфликты происходили. "

Другие эксперты, однако, полагали, что КПК не будет возражать против начала такого конфликта, если она увидит четкий путь к победе.

«Китайцы не будут ограничены нашим сводом правил», — сказал Фанелл. «Они сделают все возможное, чтобы победить. "

Полагаться на шепот военного советника ИИ, который вселяет уверенность, обрабатывая горы данных и создавая убедительные боевые планы, может быть особенно опасно, поскольку это может создать видение победы там, где раньше ее не было.

«Вы можете видеть, как это может быть очень привлекательным для лиц, принимающих решения, особенно для тех, кто гиперагрессивен, как и КПК», — сказал Тайер. "Это может сделать агрессию более вероятной. "

«Есть только один способ остановить его, который заключается в том, чтобы победить его», - сказал Фанелл.

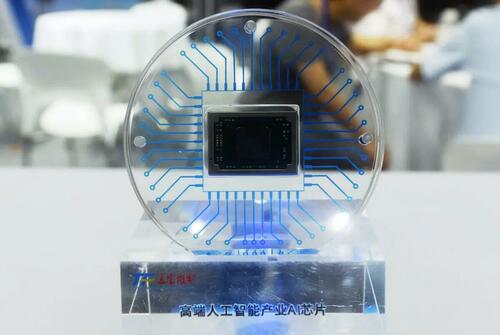

Чип искусственного интеллекта Tongfu Microelectronics отображается во время Всемирного конгресса полупроводников в Нанкине в восточной китайской провинции Цзянсу 19 июля 2023 года.

Чип искусственного интеллекта Tongfu Microelectronics отображается во время Всемирного конгресса полупроводников в Нанкине в восточной китайской провинции Цзянсу 19 июля 2023 года.Чак де Каро, бывший консультант Управления оценки сетей Пентагона, недавно призвал Соединенные Штаты разработать электромагнитное оружие, которое может отключить компьютерные чипы. Может быть даже возможно разработать энергетическое оружие, которое могло бы отключить определенный вид чипов, — написал он в статье.

"Очевидно, что без функционирующих чипов ИИ не работает."

Другим вариантом может быть разработка сверхоружия ИИ, которое может служить сдерживающим фактором.

Существует ли Манхэттенский проект искусственного интеллекта, который делают США, который может создать эффект, который Нагасаки и Хиросима окажут на КНР и Коммунистическую партию Китая, чтобы привести их к осознанию того, что, может быть, мы не хотим туда идти. Это взаимно гарантированное уничтожение? Я не знаю. Но это то, что я буду делать, — сказал Фанелл.

Это может оставить мир в противостоянии, похожем на холодную войну, — вряд ли идеальном государстве, но, вероятно, предпочтительнее, чем отменять военное преимущество КПК.

«Каждая страна знает, что это опасно, но никто не может остановиться, потому что они боятся, что их оставят позади», — сказал Ма.

Де Риддер говорит, что для прекращения гонки вооружений ИИ может потребоваться глубокий шок.

«Нам, возможно, понадобится мировая война с огромной человеческой трагедией, чтобы запретить использование автономных машин для убийства ИИ», — сказал он.

Тайлер Дерден

Туэ, 08/06/2024 - 20:05

![A gdyby tak rzucić wszystko i wyjechać do Maroka… [zdjęcia]](https://tarnow.ikc.pl/wp-content/uploads/2025/10/ucieczka-do-tangeru-fot.-Artur-Gawle0001.jpg)